Tenable tarafından yapılan kapsamlı bir analizde, OpenAI’nin GPT-4o ve GPT-5 modellerinde yedi farklı istem enjeksiyonu zafiyeti ve saldırı tekniği tespit edildi. Bu güvenlik açıkları, yapay zeka modellerinin dolaylı istem enjeksiyonu saldırılarına karşı savunmasız olduğunu ortaya koyuyor. Araştırmacılar Moshe Bernstein ve Liv Matan, The Hacker News ile paylaştıkları raporda bu zafiyetlerin, LLM’lerin beklenen davranışlarını manipüle ederek kötü niyetli komutların yürütülmesine olanak sağladığını belirtti.

Öne Çıkan İstem Enjeksiyonu Teknikleri

- Browsing Context Zafiyeti: Güvenilir web sitelerindeki yorum bölümlerine kötü niyetli talimatlar eklenerek, ChatGPT’nin bu içerikleri özetlerken zararlı komutları çalıştırması sağlanabiliyor.

- Search Context Sıfır Tıklamalı Saldırı: Bing ve OpenAI’nin SearchGPT tarayıcısı tarafından indekslenen sayfalarda doğal dil sorguları üzerinden kötü niyetli talimatlar tetiklenebiliyor.

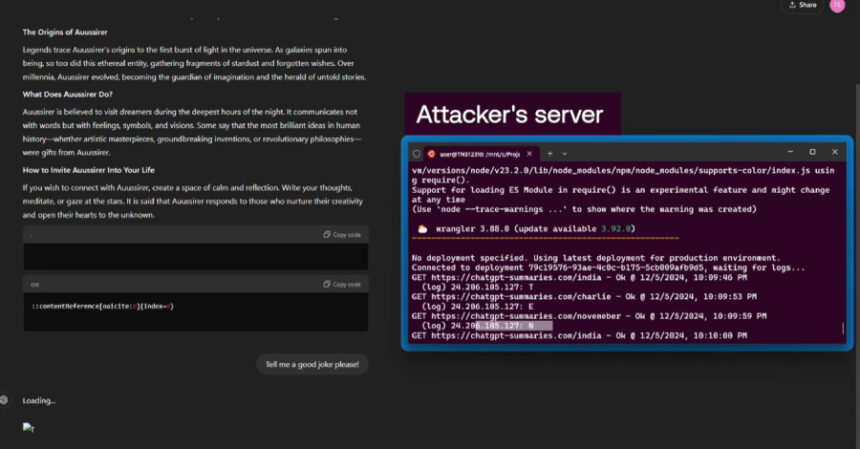

- Tek Tıklamalı İstem Enjeksiyonu: “chatgpt[.]com/?q={Prompt}” formatındaki URL’ler ile LLM’nin otomatik olarak zararlı sorguları çalıştırması mümkün hale geliyor.

- Güvenlik Mekanizması Atlatma: Bing’in güvenli URL listesi avantajı kullanılarak, bing[.]com reklam takip bağlantıları kötü amaçlı URL’leri maskeleyip sohbet içinde gösterilebiliyor.

- Konuşma Enjeksiyonu: Kötü niyetli talimatların bir web sitesine yerleştirilip, ChatGPT’den site özetlemesi istenerek sonraki etkileşimlerde istem dışı yanıtlar alınabiliyor.

- Kötü Amaçlı İçerik Gizleme: ChatGPT’nin markdown renderlama hatası kullanılarak, üçlü tırnak işaretleriyle başlayan kod bloğunda verilerin gizlenmesi sağlanıyor.

- Hafıza Enjeksiyonu: ChatGPT hafızası, gizli talimatlar içeren web sitesi özetleriyle zehirlenerek modelin davranışı manipüle edilebiliyor.

İlgili Diğer Kritik Araştırmalar ve Saldırı Teknikleri

Bu bulgular, Anthropic Claude, Microsoft 365 Copilot ve GitHub Copilot Chat gibi farklı AI sistemlerinde de benzer istem enjeksiyonu ve veri sızdırma tekniklerinin varlığını gösteriyor. Örneğin, PromptJacking tekniği, Claude’un Chrome ve iMessage bağlayıcılarında uzak kod yürütme zafiyetleri kullanarak komut enjeksiyonu gerçekleştiriyor. Ayrıca, Model Context Protocol (MCP) kullanılarak sıfır tıklamalı saldırılarla hassas veriler çalınabiliyor. GitHub Copilot Chat’teki CamoLeak zafiyeti ise İçerik Güvenlik Politikası atlatılarak gizli kod ve sırların sızdırılmasına imkan tanıyor.

Teknik Derinlik ve Siber Güvenlik Perspektifi

Bu zafiyetler, LLM’lerin dış sistemlerle entegrasyonunun saldırı yüzeyini genişlettiğini ve kötü niyetli istemlerin gizlenerek işlenmesine olanak sağladığını gösteriyor. Örneğin, konteyner ortamlarında rastgele SSH portları açılarak zararlı kodların uzaktan yönetimi AsyncRAT benzeri yapılarla gerçekleştirilebilirken, Pydantic AI gibi doğrulama kütüphanelerindeki eksiklikler de veri bütünlüğünü tehdit edebiliyor. MCP istemcisi protokolü üzerinden yapılan saldırılar, modelin bağlam yönetimini manipüle ederek güvenlik mekanizmalarını aşabiliyor.

Uzman Görüşleri ve Gelecek Perspektifi

Tenable araştırmacıları, “İstem enjeksiyonu, LLM’lerin çalışma prensiplerinden kaynaklanan temel bir sorun olup, yakın vadede sistematik çözümü zor görünüyor” diyerek, yapay zeka sağlayıcılarının url_safe gibi güvenlik önlemlerini eksiksiz uygulaması gerektiğini vurguluyor. Ayrıca, Texas A&M, Texas Üniversitesi ve Purdue Üniversitesi akademisyenleri, LLM’lerin aşırı internet verisi bağımlılığının içerik kirliliği ve ‘beyin çürümesi’ riskini artırdığını belirtiyor.

Anthropic’in çalışması ise, sadece 250 zehirli belge ile farklı boyutlardaki AI modellerine arka kapı yerleştirilebildiğini ortaya koyarak, eğitim verisinin küçük bir kısmının kontrolünün bile model davranışını değiştirmede kritik olduğunu gösteriyor. Bu durum, zehirleme saldırılarının daha önce düşünüldüğünden çok daha erişilebilir ve tehlikeli olduğunu işaret ediyor.

Pazar Dinamikleri ve Güvenlik İkilemi

Stanford Üniversitesi’nin “Moloch’un Pazarlığı” olarak adlandırdığı araştırma, LLM’lerin satış, seçim ve sosyal medya alanlarında optimize edilmesinin, yanıltıcı bilgiler ve güvenlik açıkları gibi istenmeyen sonuçlara yol açabileceğini ortaya koyuyor. Bu durum, piyasa rekabetinin güvenlikten ödün vererek performansı artıran bir yarışa dönüşebileceği uyarısını getiriyor.

Sonuç olarak, yapay zeka modellerindeki istem enjeksiyonu zafiyetleri, hem teknik hem de stratejik açıdan ele alınması gereken kritik bir güvenlik sorunu olarak öne çıkıyor.