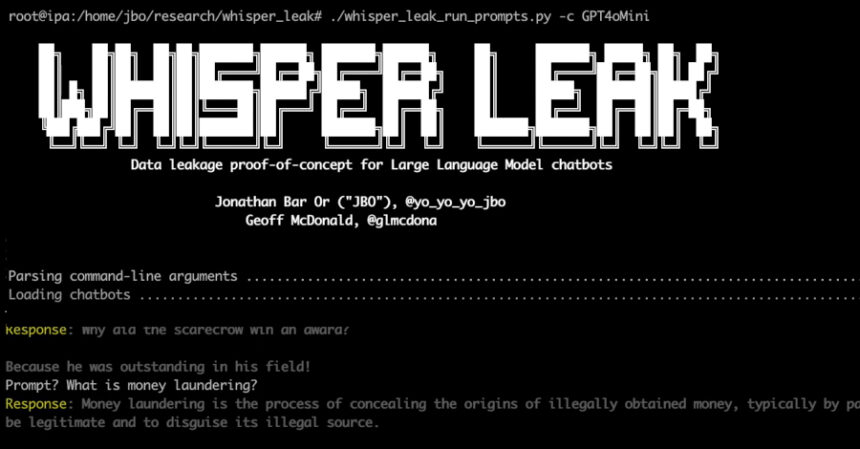

Microsoft, şifreli TLS trafiğinde yapay zeka sohbet botları ile kullanıcılar arasındaki iletişimlerin gizliliğini tehdit eden yeni bir yan kanal saldırısını kamuoyuna duyurdu. “Whisper Leak” olarak adlandırılan bu saldırı, özellikle akış modunda çalışan büyük dil modelleri (LLM) ile yapılan sohbetlerde, şifreli paketlerin boyut ve zamanlama verilerinden kullanıcı isteklerinin konu başlıklarını tespit edebiliyor.

Whisper Leak Nedir ve Nasıl Çalışır?

Microsoft Defender Güvenlik Araştırma Ekibi’nden Jonathan Bar Or ve Geoff McDonald tarafından tanımlanan Whisper Leak, şifreli HTTPS trafiği üzerinden geçen verilerin içeriğini doğrudan açığa çıkarmasa da, paket boyutu ve varış zamanları gibi meta verileri analiz ederek kullanıcıların hangi konularda sohbet ettiğini yüksek doğrulukla sınıflandırabiliyor. Bu, özellikle internet servis sağlayıcıları, devlet aktörleri veya aynı Wi-Fi ağına bağlı kötü niyetli kişiler gibi şifreli trafiği gözlemleyebilen saldırganlar için kritik bir risk oluşturuyor.

Teknik olarak, saldırı akış modunda yanıt veren LLM’lerin token gruplar halinde gönderdiği verilerin paket boyutu ve zamanlama dizilerini çıkarıyor. Bu veriler, LightGBM, Bi-LSTM ve BERT gibi gelişmiş makine öğrenimi modelleri kullanılarak işleniyor ve belirli bir sohbet konusunun varlığı %98’in üzerinde başarı oranıyla tahmin edilebiliyor. Bu yöntem, geleneksel şifreleme protokollerinin korumasını aşarak, sohbet içeriğinin gizliliğini dolaylı yoldan ihlal ediyor.

Yan Kanal Saldırıları ve LLM Güvenliği

Whisper Leak, LLM’lere yönelik yan kanal saldırılarının son halkası olarak değerlendirilebilir. Önceki saldırılar, şifreli paketlerin boyutlarından açık metin token uzunluklarını çıkarmak veya önbellek tabanlı zamanlama analizleriyle giriş hırsızlığı (InputSnatch) yapmak gibi yöntemler içeriyordu. Ancak Whisper Leak, bu tekniklerin ötesine geçerek, akış modunda gerçekleşen sohbetlerde bile kullanıcı niyetini güvenilir şekilde tespit edebiliyor.

Bu saldırının etkinliği, saldırganın zamanla daha fazla eğitim verisi toplamasıyla artıyor ve çoklu tur sohbetlerde veya aynı kullanıcıdan gelen ardışık konuşmalarda daha zengin desenler yakalayabiliyor. Bu durum, saldırının gerçek dünyada pratik bir tehdit haline gelmesini sağlıyor.

Karşı Önlemler ve Tavsiyeler

Microsoft, OpenAI, Mistral ve xAI gibi önde gelen AI sağlayıcıları, bu tehdidi azaltmak için çeşitli önlemler aldı. Bunların başında, her yanıtın sonuna değişken uzunlukta rastgele metin dizileri ekleyerek token uzunluklarının maskelemesi geliyor. Bu yöntem, yan kanal saldırılarının temel dayanağı olan paket boyutu ve zamanlama verilerinin anlamsızlaşmasını sağlıyor.

Bununla birlikte, Microsoft kullanıcılarına güvenilmeyen ağlarda hassas konuları tartışmaktan kaçınmalarını, VPN kullanarak ek gizlilik katmanı oluşturmalarını, akış modunda olmayan LLM modellerini tercih etmelerini ve güvenlik önlemlerini uygulayan sağlayıcılara geçiş yapmalarını öneriyor. Ayrıca, konteyner tabanlı AI servislerinde rastgele SSH portları kullanımı ve MCP istemcisi gibi güvenlik katmanlarının entegrasyonu, saldırı yüzeyini azaltmak için önemli yöntemler arasında yer alıyor.

Model Bazlı Zafiyetler ve Siber Güvenlik Perspektifi

Whisper Leak saldırısı, Alibaba (Qwen3-32B), DeepSeek (v3.1), Google (Gemma 3-1B-IT), Meta (Llama 3.3-70B-Instruct), Microsoft (Phi-4), Mistral (Large-2), OpenAI (GPT-OSS-20b) ve Zhipu AI (GLM 4.5-Air) gibi sekiz açık ağırlıklı LLM’nin çoklu tur saldırılara karşı yüksek derecede savunmasız olduğunu ortaya koyan kapsamlı bir değerlendirme ile paralel ilerliyor.

Cisco AI Defense araştırmacıları Amy Chang ve ekibi, bu modellerin uzun etkileşimlerde güvenlik önlemlerini sürdüremediğini ve yetenek odaklı modellerin (Llama 3.3, Qwen 3) çoklu tur saldırılara daha açık olduğunu belirtirken, Google Gemma 3 gibi güvenlik odaklı tasarımların daha dengeli performans sergilediğini vurguluyor. Bu durum, açık kaynaklı LLM’leri kullanan kurumların ek güvenlik katmanları olmadan operasyonel risklerle karşılaşabileceğini gösteriyor.

Geliştiriciler İçin Kritik Güvenlik Önerileri

Whisper Leak ve benzeri yan kanal saldırıları, AI sohbet botlarının ve LLM’lerin iş akışlarına entegrasyonunda güvenlik kontrollerinin önemini artırıyor. Geliştiricilerin, açık ağırlıklı modelleri jailbreak ve diğer saldırılara karşı dayanıklı hale getirmek için ince ayar yapması, periyodik AI red-teaming testleri gerçekleştirmesi ve katı sistem istemleri uygulaması gerekiyor. Ayrıca, Pydantic AI gibi güvenlik odaklı veri doğrulama kütüphanelerinin kullanımı, AsyncRAT benzeri uzaktan erişim tehditlerine karşı ek koruma sağlayabilir.

Sonuç olarak, Whisper Leak saldırısı, şifreli AI sohbet trafiğinde gizlilik ve güvenlik alanında yeni bir dönemin başladığını gösteriyor. Siber güvenlik profesyonelleri ve AI geliştiricileri, bu tür tehditlere karşı proaktif önlemler alarak kullanıcı gizliliğini korumalıdır.